A evolução das redes wireless trouxe consigo uma crescente demanda por escalabilidade, flexibilidade e automação. Em ambientes corporativos com dezenas, centenas ou até milhares de Access Points (APs), a atribuição manual de configurações pode se tornar impraticável. É nesse cenário que o recurso AP Filter se destaca nas controladoras Cisco Catalyst 9800, permitindo uma configuração automatizada, inteligente e baseada em regras de correspondência usando expressões regulares (regex).

O que é o AP Filter?

O AP Filter é um mecanismo que permite atribuir automaticamente as três principais tags da arquitetura baseada em tags da Catalyst 9800:

- Policy Tag

- Site Tag

- RF Tag

Essas tags controlam como o AP atua, quais políticas são aplicadas e como o rádio é configurado. Com o AP Filter, essas associações são feitas com base em regras de correspondência com nomes de AP, sem necessidade de intervenção manual por AP.finidos pelo administrador, sem necessidade de intervenção manual por AP.

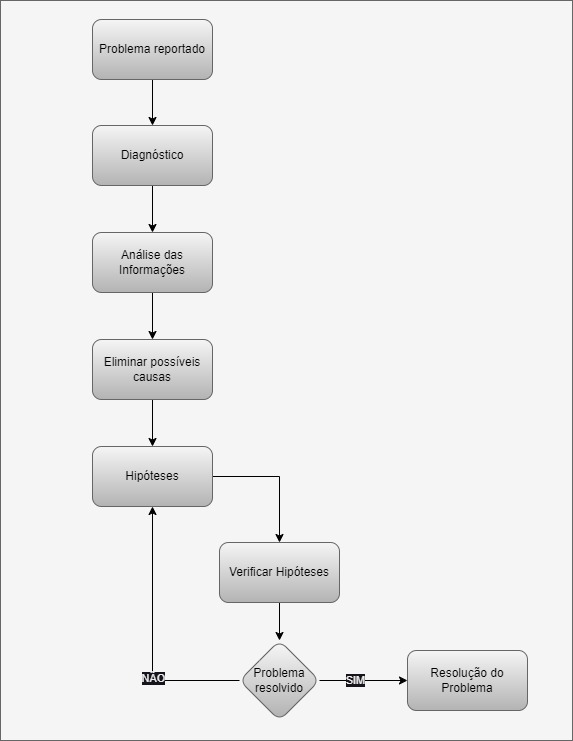

Como funciona

O mecanismo avalia o nome do AP no momento em que ele se registra na controladora (Join) e verifica se existe alguma regra de AP Filter configurada. Caso exista, a controladora aplica a combinação de tags definida na regra.

Caso nenhuma regra seja satisfeita, o sistema aplica as tags definidas como default.

Condições de Correspondência (Match Conditions)

As regras usam expressões regulares (regex) aplicadas ao nome do AP (AP Name) como base de correspondência.

Você pode usar expressões como:

^RJ-.*→ corresponde a qualquer nome de AP que começa com “RJ-“.*C9136.*→ corresponde a nomes que contenham “C9136”.*-HOSP-[0-9]{2}$→ corresponde a nomes terminando em “-HOSP-01”, “-HOSP-99”, etc.

Essas condições são altamente úteis para aplicar políticas por região, por modelo de AP, ou por qualquer outro critério lógico de agrupamento.gião, por modelo de AP, ou por qualquer outro critério lógico de agrupamento.

Estrutura de uma Regra

Cada regra de AP Filter possui:

- Expressão regular (Regex)

- Associação de Tags (Policy Tag, Site Tag e RF Tag)

- Prioridade (ordem na lista de filtros, de cima para baixo)

A ordem de avaliação respeita a ordem das regras na lista: a primeira correspondência válida é aplicada.

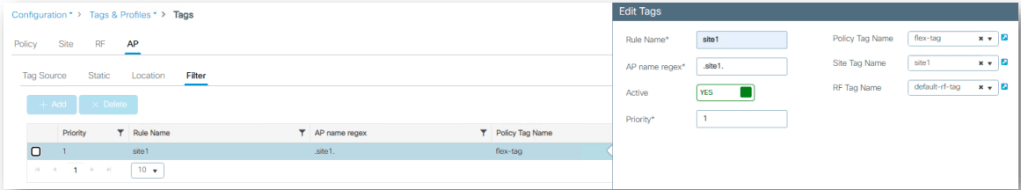

Configuração via GUI

A interface gráfica da controladora Catalyst 9800 facilita a configuração dos AP Filters:

- Navegue até:

Configuration > Tags & Profiles > Tags > AP > Filter

- Clique em Add

- Defina a expressão regular para o nome do AP

- Associe as tags desejadas (Policy, Site, RF)

- Reorganize a prioridade das regras, se necessário

- Salve e aplique

Exemplo prático

Vamos imaginar o seguinte cenário: você tem APs em diferentes cidades do Brasil. Para automatizar o comportamento esperado, você cria filtros como:

| Regex Match Condition | Policy Tag | Site Tag | RF Tag |

|---|---|---|---|

^SP-.* | pt_sp | st_sp | rf_sp |

^RJ-.* | pt_rj | st_rj | rf_rj |

.* (padrão genérico) | pt_default | st_default | rf_default |

Resultado: assim que o AP “SP-AP01” se registra, a controladora automaticamente associa as tags da primeira regra com correspondência.

Exemplos com Expressões Regulares (Regex)

A AP Filter suporta regex como método avançado de correspondência, permitindo maior controle em ambientes com regras complexas de nomeação. Veja alguns exemplos:

| Regex Match Condition | Policy Tag | Site Tag | RF Tag |

^NE-[A-Z]{2}-\d+ | pt_ne | st_ne | rf_ne |

.*C9130AX[E,I].* | pt_model | st_model | rf_model |

.*-HOSP-[0-9]{2}$ | pt_hosp | st_hosp | rf_hosp |

Explicando alguns padrões:

^NE-[A-Z]{2}-\d+→ corresponde a nomes comoNE-BA-01,NE-PE-10.*C9130AX[E,I].*→ corresponde a qualquer AP modeloC9130AXEouC9130AXI.*-HOSP-[0-9]{2}$→ identifica APs localizados em hospitais com nomes comoAP-SP-HOSP-01

Dica: Teste suas expressões em ambientes de homologação antes de aplicá-las em produção.

Benefícios do uso de AP Filter

- Escalabilidade: elimina a necessidade de atribuição manual em ambientes grandes

- Agilidade: APs entram na rede já com as configurações corretas

- Padronização: garante consistência por localização, modelo ou outro critério

- Automação: facilita integração com processos de PnP (Plug and Play)

Boas práticas

- Use nomenclatura de APs consistente para facilitar o uso de regex

- Priorize regras específicas antes das genéricas

- Sempre configure uma regra genérica como fallback

- Documente suas regras para manter clareza na operação

Conclusão

O AP Filter representa um avanço significativo na automação e escalabilidade da infraestrutura wireless com Cisco Catalyst 9800. Em vez de depender de configuração manual, a controladora toma decisões inteligentes com base em expressões regulares definidas pelo administrador. Isso resulta em uma gestão mais eficiente, menos propensa a erros e alinhada com as melhores práticas de redes corporativas modernas.

Com o uso inteligente do AP Filter, sua rede wireless está pronta para crescer de forma organizada, segura e automatizada.